Floating Point precision formats

小于 1 分钟

Floating Point precision formats

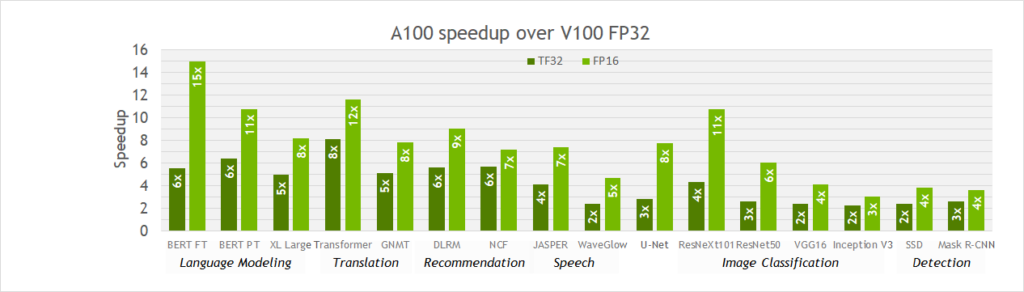

参考:https://developer.nvidia.com/blog/accelerating-ai-training-with-tf32-tensor-cores/

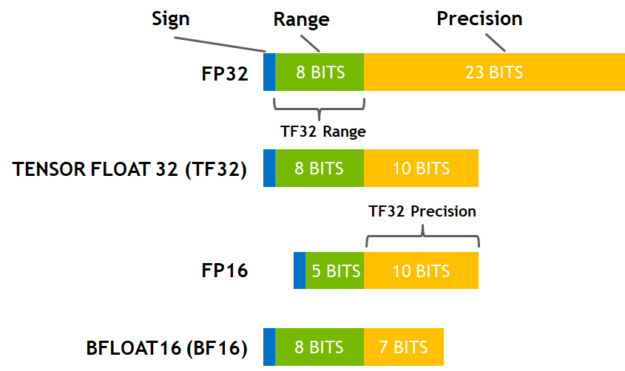

在深度学习中,范围比精度更重要。

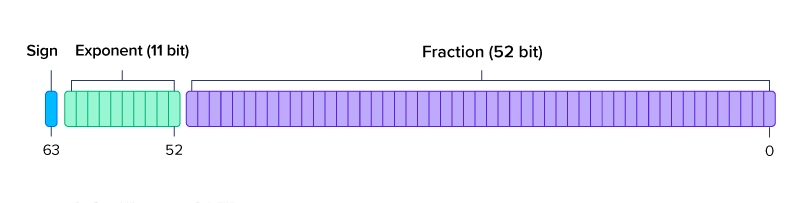

FP64

双精度

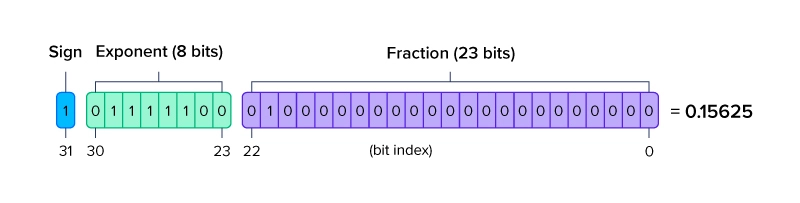

FP32

单精度

TF32

用于A100架构TensorCore,指数范围i与FP32相同,尾数范围与FP16相同。兼容FP32和FP16,只需截断就可相互转换。先截断为TF32计算再转为FP32对历史工作无影响,且无需更改代码即可使用。

更少bit的尾数意味着所需要的乘法器位宽更低,即可以实现更小的芯片面积或更高的计算密度。

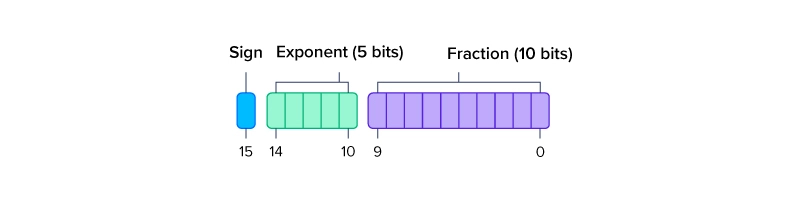

FP16

半精度

BF16

-D5lyRa7f.jpg)

Brain Floating Point Format, 谷歌提出,在FP16基础上提升指数范围,减少尾数范围